¿Cuánto hay de realidad en todo esto? ¿Cuánto hay de burbuja y de cortina de humo? ¿Qué implicaciones tienen los últimos desarrollos de la inteligencia artificial para el sindicalismo combativo, para la izquierda en general y para el cambio social?

Qué es la inteligencia artificial

La inteligencia artificial (IA) es una rama de la informática que busca automatizar tareas complejas realizadas por las personas. Pero, ¿qué es la inteligencia? Este concepto no tiene una definición clara ni unos límites precisos, pero se utiliza en este contexto por dos motivos. En primer lugar, porque las investigaciones de IA se basan en parte en el estudio de los mecanismos de la inteligencia humana (biológica) para intentar reproducirlos en un ordenador. En segundo lugar, porque las tareas complejas que se intentan automatizar con los sistemas informáticos se asocian normalmente con la inteligencia humana, aunque no exista una definición exacta de inteligencia.

La inteligencia artificial, como la informática en general, se basa en algoritmos. Los algoritmos son procedimientos con pasos definidos que pueden ser ejecutados por un sistema informático, como si fuera una receta o una fórmula matemática. Introduces el algoritmo y los datos de entrada en el ordenador y el ordenador te devuelve un resultado.

La inteligencia artificial nació como disciplina en los años 50 del siglo XX y desde entonces se ha desarrollado a través de diferentes enfoques o modelos. O paradigmas, como les gusta decir a las informáticas.

El primer paradigma de la inteligencia artificial, dominante hasta los años 80 del pasado siglo fue el de la inteligencia artificial simbólica o sistemas expertos.

Los sistemas expertos se basan en algoritmos complejos y lograron resultados notables para resolver problemas bien definidos, como jugar al ajedrez, donde las reglas están claras, no existen ambigüedades y las distintas posibilidades pueden representarse de forma sencilla en un sistema informático.

Con los sistemas expertos, el ordenador era capaz de encontrar el movimiento de ajedrez más adecuado en cada momento de la partida, pero solo en base a las reglas previamente indicadas por la persona programadora, es decir, se limitaba a aplicar el algoritmo (la receta, la fórmula).

En los 80 surgió un nuevo paradigma, la inteligencia artificial sub simbólica, y dentro de este modelo, el aprendizaje automático (machine learning en inglés).

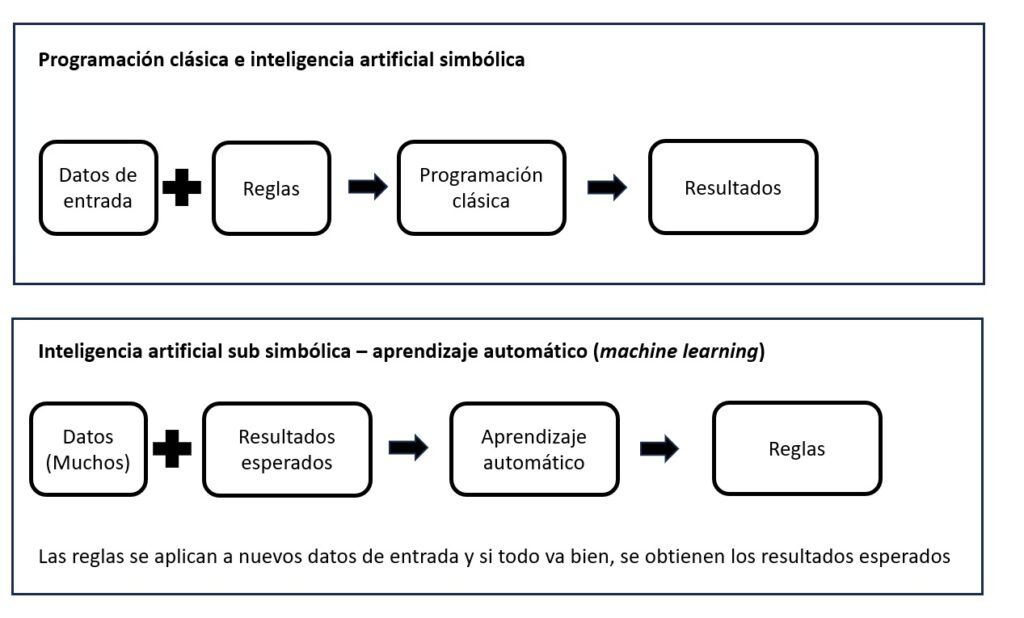

En los programas informáticos clásicos y en la IA simbólica, partíamos de unos datos de entrada y un algoritmo y de ahí obteníamos un resultado.

Con el aprendizaje automático, le damos al ordenador un gran conjunto de datos de entrada y de resultados esperados, junto a un algoritmo para que sea el propio ordenador quien busque las reglas que permitan automatizar la tarea y obtener los resultados correctos.

Por ejemplo, para la tarea de etiquetar fotos, en vez de hacer un algoritmo con reglas de etiquetado (por ejemplo, si aparecen líneas rectas, etiqueta como “edificio”, si aparecen formas parecidas a una cara etiqueta como “personas”, si no aparecen los elementos anteriores etiqueta como “paisaje”), con el modelo de aprendizaje automático, le proporcionamos al sistema informático un gran conjunto de fotos ya etiquetadas y el algoritmo encuentra por sí mismo unas reglas para etiquetar nuevas fotos.

La evolución del aprendizaje automático se produce a partir del comienzo del siglo XXI y se denomina aprendizaje profundo (Deep learning).

El aprendizaje profundo se basa en representar los datos que queremos analizar en varias capas (como si fueran estratos), y por eso es profundo, porque tiene varias capas, no porque aprenda con profundidad ni nada parecido.

Estos modelos de capas (a veces de cientos de capas) se basan en el funcionamiento de las neuronas del cerebro y por eso se denominan también como “redes neuronales”.

El aprendizaje profundo se ha desarrollado sobre todo desde 2010 y ha conseguido buenos resultados en tareas donde el aprendizaje automático convencional no avanzaba mucho: clasificación de imágenes, reconocimiento de lenguaje humano, traducción automática, conversión de texto a voz (como los robots tipo Alexa), conducción autónoma de vehículos.

Con el aprendizaje profundo, la inteligencia artificial puede analizar imágenes, sonidos, textos… y sacar de ahí mucha información, casi como haría una persona humana. Pero esto no quiere decir que el sistema informático comprenda lo que analiza ni que entienda nada, lo que hace es clasificar.

Además de la IA de clasificación, existe otra vertiente que es la generativa, es decir, partiendo de un gran volumen de datos, por ejemplo, imágenes, los algoritmos de IA pueden generar nuevas imágenes, como un cartel, un diseño o un dibujo.

- Hasta dónde llega la inteligencia artificial

Los sistemas de inteligencia artificial sub simbólica (de aprendizaje automático y aprendizaje profundo) necesitan por lo general varios elementos. En primer lugar, un conjunto de datos muy grande, por eso los últimos desarrollos de la IA están vinculados a las técnicas de manejo de grandes volúmenes de información (Big Data). En segundo lugar, un trabajo humano manual inicial -muy grande también- para preparar los datos de manera que tengan sentido para el sistema (por ejemplo, etiquetando a mano los millones de fotos que el algoritmo de IA necesita para entrenar y descubrir por sí mismo reglas de etiquetado). En tercer lugar, la IA necesita una gran capacidad de computación para obtener resultados en un tiempo razonable.

Todo esto introduce la dimensión ecológica de la inteligencia artificial, pues estos sistemas necesitan de grandes cantidades de datos y de una gran potencia de computación, es decir, de centros de datos que consumen una gran cantidad de energía y sobre todo de agua. Como plantea Aura Gómez en el número 117 de Libre Pensamiento dedicado a la transición ecosocial, los centros de datos, que es donde entrenan los sistemas de inteligencia artificial, suponen una amenaza para la vida en los territorios donde se instalan y para el planeta en su conjunto.

Los algoritmos de inteligencia artificial no son capaces de razonar, ni de comprender, ni de abstraer, ni de aplicar los resultados de una situación para aplicarlos en otra. Cuando se afirma que un algoritmo de inteligencia artificial “aprende”, es bueno tener en cuenta estos aspectos, porque no “aprende” en el sentido que lo hacemos las personas, sino que es capaz de clasificar o generar información con unos criterios que ha obtenido por sí mismo, en un contexto concreto, no aplicable a otro contexto distinto. Es decir, que el algoritmo que es capaz de vencer al ajedrez a cualquier persona, no es capaz de aplicar todo el conocimiento que tiene sobre ajedrez a ninguna otra actividad.

Con estas limitaciones, la IA está muy lejos de adquirir conciencia de sí misma y de establecer sus propios objetivos, un tema recurrente en la ciencia ficción desde hace décadas. ¿Cómo va a adquirir conciencia de sí mismo un algoritmo que ni siquiera es capaz de comprender, de abstraer, de hacer analogías o de razonar?

- Los límites y el negocio de la IA

Teniendo claras estas limitaciones de la IA, podemos apreciar mejor las aportaciones que supone esta tecnología. La IA ha conseguido resultados sorprendentes en tareas específicas, que no tienen mucho que ver con la comprensión ni la inteligencia, pero que son sin duda positivos.

Con los condicionantes anteriormente expuestos (conjunto de datos muy grande, gran capacidad de computación, gran cantidad de trabajo humano de clasificación inicial), los algoritmos de IA son capaces de clasificar imágenes de forma muy útil para el diagnóstico médico, de traducir textos, de transcribir conversaciones a texto, de convertir texto en conversaciones, de procesar imágenes para el diagnóstico clínico o la conducción automática de vehículos… y en general, de analizar enormes conjuntos de datos para encontrar patrones.

La IA supone un avance tecnológico incuestionable, con impacto en la sociedad. Es una ayuda en algunos trabajos y actividades cotidianas, pero no está nada claro que vaya más allá ni que suponga un cambio social profundo.

Los algoritmos de IA son capaces de transformar nuestra conversación en instrucciones para que el ordenador o el móvil responda, ya sea en modo texto o incluso con una locución.

Los algoritmos de IA como ChatGPT son capaces de generar un informe o un texto a partir de muy pocas palabras clave. Pero el algoritmo no entiende lo que está escribiendo ni es capaz de razonar nada. Nos ofrece una plantilla de texto muy mejorada y muy redactada, pero es eso nada más: una plantilla. Si esta plantilla generada con IA nos ahorra mucho trabajo, por ejemplo para hace informes o trabajos académicos, es muy posible que el trabajo fuera mecánico y necesitara poca inteligencia para su realización.

Las promesas de que en pocos años la IA será capaz de comprender, de razonar e incluso de adquirir conciencia se vienen repitiendo desde hace cincuenta años y siguen estando muy lejos de la realidad.

Estas promesas poco realistas obedecen principalmente a dos motivos. En primer lugar, se utilizan por los investigadores e ingenieros de IA para atraer más financiación a sus proyectos. En segundo lugar, se usan por las empresas para aumentar el valor de sus acciones.

Efectivamente, es una lógica muy parecida a las burbujas de otros ámbitos de la economía como la de la vivienda o en su día la de las empresas tecnológicas.

La IA se ha convertido en la última promesa tecnológica que surge cada pocos años para intentar convencernos de que cambiará el mundo para siempre. Ahora se habla de IA, pero hace años fue el metaverso (un universo paralelo que mezclaría la realidad virtual con la realidad física), del que ya apenas queda su recuerdo, el blockchain (la base tecnológica de las criptomonedas), la robotización (que iba a acabar con gran parte del trabajo humano), el internet de las cosas (que iba a permitir que los electrodomésticos de las casas se comunicaran entre sí, al igual que los robots de las fábricas…).

Cada una de estas promesas tecnológicas ha supuesto sin duda transformaciones en el empleo o incluso en la vida diaria, pero de mucho menor impacto de lo que prometían quienes buscaban financiación para sus proyectos o de quienes intentaban inflar el precio de sus acciones.

La inteligencia artificial, como todo cambio tecnológico provoca cambios en la economía. Unos empleos se degradan, otros desaparecen (incluso profesiones enteras) y también surgen nuevos puestos. Cada cambio tecnológico con impacto en el empleo nos obliga a reflexionar al sindicalismo de clase en general y al anarcosindicalismo en particular ¿qué empleos son socialmente necesarios o positivos para defenderlos con todas nuestras fuerzas? ¿es factible reclamar empleo para todas o es más adecuado reclamar ingresos dignos/suficientes para todas en forma de renta básica puesto que no hay empleo suficiente? Por otro lado, cada cambio tecnológico también nos impulsa a reflexionar sobre la necesidad de que el control de las empresas esté en manos del pueblo y no de los empresarios, de manera que las nuevas tecnologías se orienten a mejorar la vida, reducir la pobreza y la desigualdad, ayudarnos a ser más felices, menos individualistas, y no a engordar las cuentas corrientes de unos pocos privilegiados generando adicciones a tecnologías que no necesitamos para una vida buena.

- El riesgo son los algoritmos y los procesos de decisión automáticos, no solo la inteligencia artificial

Pero también se utilizan algoritmos de inteligencia artificial para distribuir cargas de trabajo dentro de la empresa, para evaluar el rendimiento de las personas trabajadoras y así decidir salarios o incluso despidos.

Y aquí el problema no es tanto que se utilice un algoritmo con inteligencia artificial como que se utilice un algoritmo que enmascara los criterios de decisión. La clave no está tanto en el tipo de algoritmo que se utiliza (tradicional, IA simbólica, aprendizaje automático, aprendizaje profundo…) sino el hecho de que empresas y organismos públicos toman decisiones que afectan a nuestros derechos laborales, civiles o sociales con criterios secretos.

Ciertamente, el uso de la inteligencia artificial supone una dificultad añadida, puesto que estos sistemas son muy difíciles de auditar, incluso por especialistas, y en algunos casos es sencillamente imposible saber por qué un sistema de IA ha encontrado ciertos patrones u ofrece ciertos resultados.

Cualquier procedimiento automático de decisión que afecte a los derechos de las personas, debería basarse en criterios públicos, es decir, el algoritmo debe poder auditarse para comprobar, por ejemplo, que no discrimina a las mujeres, a las personas racializadas, a las afiliadas a un sindicato… etc.

Actualmente en España se están utilizando algoritmos por las empresas y la Administración para tomar decisiones de gran impacto sobre nuestras vidas.

La multinacional de reparto Glovo distribuye las cargas de trabajo a sus empleados utilizando un algoritmo que continúa siendo secreto a pesar de las reclamaciones de los sindicatos de clase.

El Ministerio del Interior utiliza el algoritmo Viogén para determinar el nivel de riesgo para la vida de las mujeres denunciantes de violencia de género. Y a cada nivel de riesgo le corresponde un nivel de protección, por lo que es una cuestión de vida o muerte. El algoritmo es secreto y los colectivos feministas sospechan que el sistema informático valora mal el riesgo de forma sistemática o que incluso rebaja el nivel de riesgo cuando no hay agentes policiales disponibles para dar protección y así ocultar la responsabilidad de la policía.

En Catalunya, la Administración de Justicia utiliza el algoritmo Riscanvi para determinar el riesgo de reincidencia de las personas presas y de esta manera conceder progresiones de grado (hasta la libertad condicional). De nuevo, se trata de un algoritmo secreto.

El Gobierno de España ha desarrollado el algoritmo Bosco para decidir si una persona tiene derecho al bono social de la electricidad, y lo ha puesto a disposición de las empresas eléctricas. La fundación Civio ha demandado en el juzgado para poder acceder al contenido del algoritmo y comprobar que no es discriminatorio, pero de momento sin resultado.

Todos estos casos tienen una misma lógica. Las empresas y gobiernos toman decisiones que afectan a los derechos laborales, sociales o civiles por medio de algoritmos secretos. Si el algoritmo utiliza inteligencia artificial o es un algoritmo tradicional. Si se usa inteligencia artificial, el algoritmo será siempre más difícil de auditar, porque además de los pasos establecidos en el algoritmo habrá que analizar los datos con los que se entrena el algoritmo, porque si están sesgados por ejemplo con criterios racistas, machistas o clasistas, el resultado será discriminatorio, aunque el algoritmo se base en buenos principios. Si se usa inteligencia artificial es posible también que el algoritmo sea directamente imposible de auditar. En todoa los casos, la clave está en exigir el derecho a la transparencia cuando se nos aplica una decisión por medio de un algoritmo.

No puede ser que se nos aplique una decisión basada en un procedimiento secreto, en este caso un algoritmo.

En este ámbito, la Ley Rider (RDL 9/2021) añadió al Estatuto de los Trabajadores un nuevo apartado d) al artículo 64.4, generando así un nuevo derecho de la representación de las personas trabajadoras a:

“Ser informado por la empresa de los parámetros, reglas e instrucciones en los que se basan los algoritmos o sistemas de inteligencia artificial que afectan a la toma de decisiones que pueden incidir en las condiciones de trabajo, el acceso y mantenimiento del empleo, incluida la elaboración de perfiles”.

En este mismo sentido, el Reglamento General de protección de Datos de la Unión Europea (RGPD) de 2016 incluye el derecho

“a no ser objeto de una decisión, que puede incluir una medida, que evalúe aspectos personales […]y que se base únicamente en el tratamiento automatizado”.

Esto está muy lejos del derecho a la transparencia de los algoritmos o a que se garantice el derecho a saber qué criterios se utilizan para tomar decisiones que afectan a nuestros derechos.

Además, sabemos de sobra que una cosa es que exista un derecho reconocido y otra muy diferente que exista la suficiente fuerza sindical y organización social para obligar a los empresarios y al gobierno a que lo apliquen, pero sin duda es un avance.

Por tanto, tenemos que salir del marco de debate sobre la inteligencia artificial que más interesa a las empresas tecnológicas y a sus accionistas e imponer nuestro propio marco: lo importante no es tanto la IA sino la transparencia. Reclamar el derecho a conocer y a auditar los algoritmos que afectan a nuestros derechos, porque sin este derecho, volvemos al espíritu de la Inquisición española y sus procedimientos secretos en los que el reo no sabía ni quien le acusaba ni de qué se le acusaba. A veces las innovaciones tecnológicas nos hacen retroceder.

Además de conseguir la transparencia de todos los algoritmos que se utilicen para la toma de decisiones sobre nuestras vidas, existe otra línea de actuación que nos puede interesar al sindicalismo combativo y a la izquierda en general: reclamar a las instituciones que la potencia de clasificación que proporciona la IA (aunque se limite a clasificar información y no comprenda nada), se utilice para fines sociales hacia una mayor igualdad y no para aumentar la desigualdad, la discriminación y la pobreza.

Como señala con muy buen criterio la matemática e informática Ana Valdivia en la revista Contexto, sería interesante exigir que el dinero público se destine a desarrollar algoritmos que mejoren la vida de las personas y reduzcan las desigualdades. Es decir, que por ejemplo el Gobierno deje de desarrollar algoritmos para que las empresas eléctricas puedan denegar el bono social de la electricidad, y redirija esos recursos para el desarrollo de algoritmos que detecten el fraude fiscal de los empresarios o las horas extras no pagadas en sectores concretos, o la falta de medidas de seguridad y salud en las empresas.

Derecho a la transparencia y algoritmos para fines sociales. Una propuesta mucho más atractiva que el debate interesado sobre si una máquina supera en inteligencia a las personas, algo que está muy alejado de la realidad.

Para saber más:

“Si el algoritmo es racista es porque se ha entrenado con datos racistas”. Entrevista a Ana Valdivia, realizada por Elena de Sus. Ctxt, 10 de febrero de 2024

François Chollet. Deep learning con Python, Anaya 2020

Bryce Goodman, Seth Flaxman. European Union regulations on algorithmic decision-making and a “right to explanation”. ICML Workshop on Human Interpretability in Machine Learning, 2016

Melanie Mitchell. Inteligencia artificial. Capitán Swing. 2024.

Kathie O’Neill. Armas de destrucción matemática. Capitán Swing, 2018.

Paloma Llaneza. Datanomics. Deusto, 2019.

Este artículo se publicó en Libre Pensamiento nº 118. Verano 2024.